Misure al top

Una storia di incertezze

di Paolo Checchia

Al concetto stesso di misura si deve accompagnare quello di incertezza (o errore) con cui il risultato della misura è ottenuto. Troppo spesso ci si scorda che il binomio risultato-incertezza costituisce uno dei fondamenti di qualsiasi risultato scientifico. La tanto declamata “certezza scientifica” è in realtà un processo delicato, in cui si valuta se un’affermazione (come ad esempio “esiste il bosone di Higgs”, ma anche “il fumo è dannoso alla salute”) è suffragata da risultati sperimentali, la cui incertezza è tanto piccola da rendere irragionevole l’affermazione opposta. Nella fisica, e non solo, ci sono quantità che vanno misurate con la massima precisione (ovvero con il minor errore possibile) per tutta una serie di motivi, non ultimo per il fatto che una misura con un errore troppo grande non servirebbe a nulla. Se ad esempio il Gps ci desse la nostra posizione con un errore di un chilometro, è evidente che non ci sarebbe utile quando in automobile siamo alla ricerca della strada migliore. A volte è possibile ottenere misure indirette di una certa quantità in aggiunta a misure più dirette. Supponete di trovarvi in una valle in montagna e di voler sapere quanto distanti si trovano le pareti che la delimitano. Se emettete un grido e riuscite a distinguere l’eco, con un buon cronometro potete misurare il tempo intercorso tra grido ed eco e, conoscendo la velocità del suono, calcolare la distanza dalle pareti. Ovviamente questa misura (indiretta) non può essere molto precisa ma è senz’altro più immediata di una faticosa misurazione del terreno (misura diretta). In alcuni casi, poi, la misura diretta non è assolutamente realizzabile, e quella indiretta costituisce l’unica possibilità a disposizione: se vi chiedete a che distanza è avvenuto un lampo, potreste contare i secondi che vi separano dall’arrivo del tuono, ma non potreste mai recarvi nel punto in cui si è sviluppata la scarica.

Entriamo ora nel mondo delle particelle elementari, occupandoci della particella più pesante di tutte: il quark top. A partire da quando è stata ipotizzata (alla fine degli anni ’70), è stata sempre indicata come la più pesante tra i membri delle famiglie dei “fermioni”, le particelle di spin semi-intero del “modello standard”, la teoria che descrive il mondo delle particelle elementari. Ma quanto pesante? Prima di tutto si è stabilito che il quark top non poteva avere massa minore di circa la metà di quella dello Z, il bosone neutro scoperto assieme al bosone carico W da Carlo Rubbia. Nel collisore a elettroni e positroni del Cern, il Lep, si sono infatti prodotti milioni di Z e, se il quark top avesse avuto una massa sufficientemente bassa, una frazione degli Z prodotti sarebbe decaduta in una coppia formata dal top e dalla sua antiparticella, dotata della stessa massa, l’antiquark top. La mancata scoperta si è però trasformata comunque in un’informazione scientifica: un limite inferiore alla massa del quark. Non una vera misura, ma una limitazione alla nostra ignoranza, come si può vedere in fig. b, dove il limite è rappresentato dalla linea continua verde. I risultati del Lep (e di altre macchine) hanno però prodotto anche una misura indiretta della massa del top. Il Lep ha misurato, con estrema precisione, alcune proprietà di altre particelle, come le masse dei bosoni Z e W, l’intensità della loro produzione, i loro modi di decadimento ecc. Quantità apparentemente indipendenti l’una dall’altra, ma che il modello standard è in grado di mettere in relazione tra loro. È cruciale notare che le varie relazioni dipendono dalla massa del quark top, per cui è possibile ottenere un valore della massa che metta d’accordo al meglio tutte le misure. Tanto più i risultati al Lep diventavano precisi (con errori sempre più piccoli), tanto più l’incertezza nella misura indiretta della massa del top calava, come si vede dai punti verdi e dalle loro barre d’errore nella fig. b. Supponendo valido il modello standard, la massa del top era già stata misurata (circa 160 GeV/c2) con un errore del 20% prima ancora che il quark venisse scoperto. Misure effettuate a un’energia più bassa di quella necessaria per produrre il quark top, hanno permesso di estrapolare la conoscenza in regioni di energia ancora non accessibili.

b.

b.

Misure della massa del top in funzione dell’anno. La linea e i punti verdi sono i risultati del Lep, la linea e i punti viola i risultati combinati del Tevatron, con i risultati di Cdf (triangoli azzurri) e DZero (triangoli rossi), i triangoli marroni i risultati di Cms, i triangoli blu i risultati di Atlas mentre il quadrato arancione rappresenta la media mondiale nel 2014. In questi grafici, il simbolo viene posizionato sul valore più probabile, mentre le "barre d'errore", ovvero i segmenti sopra e sotto il simbolo, rappresentano l'incertezza sul risultato della misura.

c.

c.

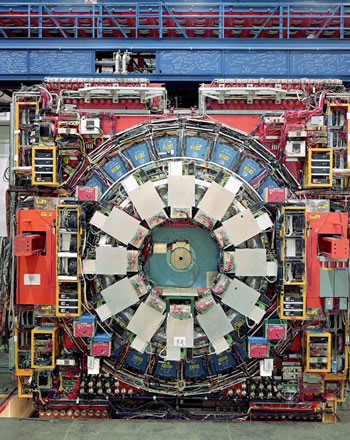

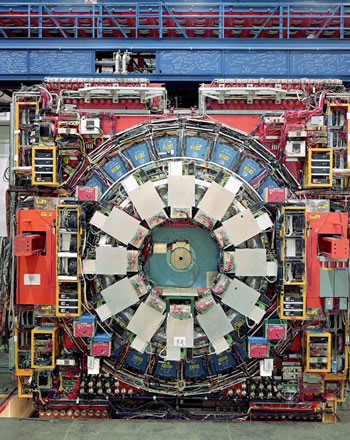

L’esperimento Cdf del Fermilab di Chicago, che nel 1995 scoprì il quark top.

L’errore che si ottiene da una misura indiretta, che proviene da misure estremamente precise, ma che risente dell’incertezza di altri parametri previsti dalla teoria, non può però competere con quello di una misura diretta. La scoperta di una particella come il quark top praticamente coincide con una misura della sua massa: il top è altamente instabile in quanto, appena prodotto e ancora allo stato di quark “libero”, decade in altre particelle. La misura diretta della sua massa si può ottenere solo con la misura di energia e direzione delle particelle prodotte dal suo decadimento. Supponendo di conoscere quali siano queste particelle e di poter osservare un certo numero di decadimenti, il segnale della presenza del top viene osservato come un picco, la cui sommità coincide proprio con la massa e la cui larghezza dipende da un’altra caratteristica (l’instabilità) e dagli errori di misura. Osservare il segnale, quindi, vuol dire misurare la massa (vd. anche

Per un pugno di sigma, ndr). Consideriamo ancora la fig. b: a partire da una certa data appaiono dei punti (i triangoli blu) con barre d’errore più piccole rispetto a quelle che corrispondono alle misure indirette. Questi punti provengono dai dati dell’esperimento Cdf del Tevatron al Fermilab (nei pressi di Chicago), che portarono alla scoperta del quark top con conseguente misura diretta della sua massa nel 1995. Si vedono apparire a breve distanza di tempo anche altri punti (i triangoli rossi), che corrispondono al segnale prodotto dal top rivelato da un altro esperimento del Fermilab, l’esperimento DZero. Si vede anche che, con l’andar del tempo, le barre d’errore dapprima si riducono rapidamente, per poi rimanere abbastanza stabili, con un andamento che permette di capire l’incertezza della misura. Al momento della scoperta, infatti, la massa della particella è misurata con un numero limitato di decadimenti: quelli sufficienti a dichiarare la scoperta, ma soggetti a grandi fluttuazioni dovute al numero statisticamente non molto significativo di dati raccolti. Queste fluttuazioni producono un’incertezza, che chiamiamo “errore statistico”, che si riduce man mano che si accumulano dati. Va notato che l’errore statistico si riduce in funzione della radice quadrata del numero di decadimenti raccolti (quella della radice quadrata è una legge del tutto generale in statistica), per cui per dimezzarlo basterebbero quattro volte tanti dati, mentre per ridurlo a un terzo del valore iniziale servirebbe un campione nove volte più grande. L’errore statistico è, però, solo una delle componenti che determinano l’incertezza totale della misura, rappresentata dalle barre d’errore: ve ne sono altre che, accumulando più dati, si riducono poco o nulla e che a lungo andare diventano dominanti.

d.

d.

Scorcio del Fermilab, nei sobborghi di Chicago (Usa).

Queste componenti le chiamiamo “errori sistematici”. Ad esempio, i rivelatori che ricostruiscono l’energia delle particelle che provengono dal decadimento del top possono essere soggetti a errori di scala nella valutazione dell’energia, che si ripercuotono sul valore della massa misurata. Oppure ci possono essere errori nell’individuazione dei segnali di fondo che, inevitabilmente, si accompagnano al segnale. O anche incertezze teoriche sulla differenza tra la massa misurata in modo diretto e quella che risulta dalle misure indirette. In sintesi: un esperimento, con lo stesso tipo di misura, non riuscirebbe ad andare oltre una certa precisione nemmeno raccogliendo moltissimi dati. In fig. b appaiono punti (quadrati viola) con errori più piccoli di quelli finora considerati: si tratta delle combinazioni delle varie misure di entrambi gli esperimenti del Tevatron. Combinare misure diverse, specie se ottenute da collaborazioni diverse, serve a diminuire l’incertezza, sia per la riduzione dell’errore statistico che per la diminuzione di alcuni effetti sistematici, qualora non fossero correlati tra gli esperimenti. L’avvento di Lhc, con il gran numero di decadimenti del top raccolti e la qualità dei rivelatori Atlas e Cms, ha permesso di migliorare ulteriormente la precisione con cui la massa del top è stata misurata: come si vede dal cambio di scala in fig. b, ora le misure di Lhc permettono di dare la massa con un errore inferiore allo 0,3%. Siamo entrati nell’era delle misure di estrema precisione della massa del top con importanti implicazioni per alcuni modelli teorici.

DOI: 10.23801/asimmetrie.2017.22.2

{jcomments on}

b.

b. c.

c.

©asimmetrie

©asimmetrie